GPT-4o es multimodal y trabaja con voz, texto e imagen al mismo tiempo

Por Orlando Rojas Pérez – El evento de hoy de OpenAi, como había anticipado el mismo Sam Altman, no era para anunciar un buscador que compita con Google ni para presentar GPT-5, su objetivo era anunciar GPT-4o con la letra o que equivale a omni. OpenIA afirma que es un gran salto y se siente muy orgulloso de sus nuevas funciones.

- Trabaja en forma simultánea -multinodal- y en forma nativa: texto, imagen y video. Sin necesidad de que se conecten varios ambientes o plataformas.

- En la demostración de la nueva velocidad y mínima latencia a la respuesta de un audio, supera a los 2,8 segundos de GPT-3.5 y los 5,4 segundos de GPT-4, con un asombroso 320 milisegundos, que iguala le velocidad de los humanos.

- ChatGPT pronto estará actualizado a GPT-4o y para todos los usuarios, que podrán manejar datos, incluso para los gratuitos sin necesidad de tener una cuenta PLUS, con una limitante el número de mensajes.

- Ahora OpenAI trabaja con más de 50 idiomas y lo hace más rápidamente.

- Los desarrolladores podrán incluir el API de OpenAI, en sus aplicaciones.

- Se pueden subir imágenes y archivos para ser analizados.

- Habrá una aplicación de escritorio para MacOS y para Windows, pero por ahora será para usuarios PLUS e inicialmente para MacOS.

e

Ver nota:

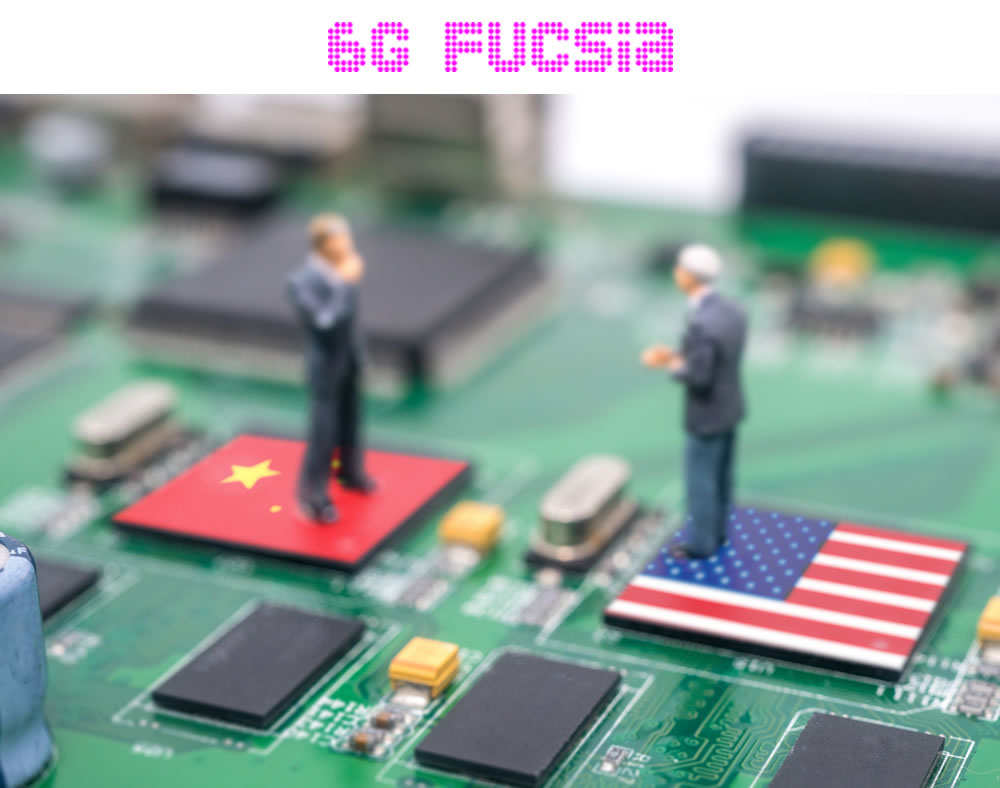

6G Fucsia – Catástrofe -Si China piensa: si no hay chips para nosotros no habrá para nadie

Intel sí se prepara, ¿Broadcom compraría a Intel?, Proyecto de ley de EEUU bloquea tecnología IA, Rusia usa IA de Kaspersky en sus drones de guerra.

http://www.evaluamos.com/?home/detail/18872